機械学習で桜の開花日を予想してみた

機械学習で予想した東京の開花日は3月25日でした。3月10日までの気象情報から推測しています。

今年は比較的暖冬で例年(平均:3月26日)より早めでしょうと言われているので、それを反映できていると思います。ちなみに、weathermap[1]の予想日は3月23日でした。(3月14日現在)

方法

気象庁公開の気象データ[2]、さくらの開花日データ[3]を使います。

気象データは任意の観測地、観測期間、観測値を指定してcsv形式で入手することが出来ます。今回は、以下の条件の観測データを学習に使用しました。

- 観測地点:東京、銚子、甲府、熊谷、水戸、長野、名古屋、静岡、津、宇都宮、横浜の11地点

- 期間:2000年~2018年までの18年分

- 観測値:平均気温、最高気温、降水量の合計、日照時間、最深積雪、降雪量の合計、平均風速、最大風速、最大瞬間風速、平均蒸気圧、平均湿度、最小相対湿度、平均現地気圧、平均海面気圧、最低海面気圧、平均雲量、10分間降水量の最大の17つ

- 観測間隔:毎日

さくら開花前年の4月1日~3月10日までの345日分のデータを使って学習します。

- 1データあたりの特徴量数は、345(日数)x17(観測値の数)=5865となります。

- 全データ数は、11(観測地点数)x18(観測年数)=198です。

学習にはランダムフォレストを使用しました。これはランダムに特徴量を選択しデータの予測を行う決定木を作成する方法です。単純な決定木よりもノイズに強いという特徴があります。また、学習の副産物として、どの特徴量が決定木の構成によく使われたのか知ることが出来るので、学習後にデータの分析をするのに役立ちます。

データの前処理

- 観測値が空白の日について、1日後の値で補完しました。

- さくらの開花日は、1月1日を0として0-364で数値化しました。

- 2月29日はデータから除外しました。

- 各特徴量は学習データの最大値、最小値で0-1に正規化しました。

学習結果のバリデーション

方法の良し悪しをクロスバリデーションで評価します。

クロスバリデーションでは、学習に使用するデータを分割して学習・予測・評価することを繰り返し、平均的な性能を見ることが出来ます。評価はMAEで行います。

これは予測誤差日数の平均ということになります。

比較を行うために、予測結果を過去の平均値とした時のMAEを計算しました。

| MAE | |

|---|---|

| 過去の平均値 | 5.36 |

| 予測値 | 2.67 |

さくらの開花日を過去の平均値として計算する場合5.36日の誤差があるが、予測をすると誤差は2.67日に減少することが分かりました。

ランダムフォレストでは、どの特徴量が予測に有効であるか知ることが出来ます。5865の特徴量のうち上位10個を挙げます。

特徴量名 重要度 重要度の累積値

Ave(tmp)[cels]_day58_2/28 0.21 0.21 Ave(tmp)[cels]_day299_10/27 0.04 0.25 Ave(tmp)[cels]_day11_1/12 0.04 0.29 Ave(tmp)[cels]_day364_12/31 0.02 0.32 Max(tmp)[cels]_day10_1/11 0.02 0.34 Ave(tmp)[cels]_day60_3/2 0.02 0.36 Max(tmp)[cels]_day59_3/1 0.02 0.38 Max(tmp)[cels]_day363_12/30 0.02 0.40 Ave(humid)[%]_day39_2/9 0.02 0.41 Ave(tmp)[cels]_day59_3/1 0.01 0.42

Ave(tmp)[cels]..平均気温

Max(tmp)[cels]..最高気温

Ave(humid)[%]..平均湿度

2月28日の平均気温が最も有効な特徴量でした。10分の9が気温に関する特徴量であり、さくらの開花予測には気温が有効であることが分かりました。また、10月以降の気温が開花日に大きく影響するが分かりました。

結果

学習に使用した観測点について今年の開花日を予想しました。

月日は四捨五入で計算しています。東京は82.58->83として3月25日になりました。

| 地点 | 開花日(0-364) | 開花日(月日) |

|---|---|---|

| 銚子 | 83.91 | 3/26 |

| 甲府 | 81.41 | 3/23 |

| 熊谷 | 82.42 | 3/24 |

| 水戸 | 83.9 | 3/26 |

| 長野 | 93.83 | 4/05 |

| 名古屋 | 80.97 | 3/23 |

| 静岡 | 80.44 | 3/22 |

| 東京 | 82.58 | 3/25 |

| 津 | 81.15 | 3/23 |

| 宇都宮 | 85.32 | 3/27 |

| 横浜 | 82.73 | 3/25 |

参考

[1]さくら開花予想2019, https://sakura.weathermap.jp/

[2]過去の気象データ, https://www.data.jma.go.jp/obd/stats/etrn/

[3]さくらの開花日, https://www.data.jma.go.jp/sakura/data/sakura003_06.html

最小二乗フィッティングで糖尿病の進行度予測

糖尿病のサンプルデータを使って最小二乗フィッティングしました。糖尿病のサンプルデータを使って最小二乗フィッティングしました。

理論

観測値は

というモデルで表されるとします。モデルが

の線形結合で表される時、

と書けます。

は

の係数です。

次のような個の観測値の集合がある場合を考えます。

この集合からモデルに最も当てはまる係数を求めるには、モデルから求めた理論値

と観測値

を最小にします。理論値と観測値の二乗誤差の総和は、

と書けます。Jを最小にすればよいということが分かります。

(2)のを行列で表すと以下のようになります。

(2)のを最小にするということは、(3)の大きさを最小にすればいいですね。簡略化&理想的な場合を考えると、(3)

と置いてこれを解けばよいということが分かります。

実装

scikit-learnのLinearRegression()を使います。[1]の例では、1次元の特徴量に限定してフィッティングしていますが、全特徴量を使ってフィッティングしました。Variance scoreはフィッテイングの良さを示す値で、データのばらつきをもとに計算します。[1]では0.47でしたが、全特徴量を使った場合0.59となり、よりよくフィッティング出来ています。

出力

Coefficients: [ 2.06069866e-04 -7.05675908e-02 4.14834780e-01 2.49574079e-01 -7.11907159e-01 4.82683572e-01 9.08289960e-02 1.50462309e-01 6.01524431e-01 6.48063127e-02] Mean squared error: 0.02 Variance score: 0.59

学習データ、テストデータをそれぞれプロットし求めたフィッティングを描画してみました。各特徴量に対する観測値の値です。プロット点はデータ、線は予測結果を表しています。各プロットのタイトルには求めた係数を表示しています。係数の大きさが大きいほど重要な特徴量と考えられるのです。ここで最も大きいものはという特徴量でしたが、プロット点を見ると観測値と相関がないように見えます。また、データの傾向に反して負の係数であるのが気になります。未解決です。

Fig1. 学習データのプロット、フィッテイング結果

Fig2. テストデータのプロット、フィッテイング結果

参考

[1]Linear Regression Example, https://scikit-learn.org/stable/auto_examples/linear_model/plot_ols.html#sphx-glr-auto-examples-linear-model-plot-ols-py

カメラの基本行列を理解する、エピポーラ線を描く

2つの画像におけるの投影点を

,

とし、それを対応付ける行列

を求めます。

を基本行列と呼び、以下が成り立ちます[1]。

の表すもの

の表すもの

,

,

の位置関係を図示するとFig1のようになっています。

Fig1. ,

,

の位置関係

は

を回転、平行移動することで表すことができるので、回転を

、平行移動を

として

と書けます。,

は同一平面上にあるので、この外積

は平面上の垂線ベクトルを表します。

また、も同様に同一平面上にあるので、垂線ベクトルと直交する(=垂線ベクトルとの内積が0となる)ことから

となります。ここで、外積を行列表現します。

の時

と表せるので、(3)は

ここで、

と表せます。は

のことですね。

また、(1)の両辺の転置を取ると、

となるので、を

に対応付ける行列は

であると言えます。

の性質

の性質

はカメラの内部パラメータで正規化済みの点

,

の対応を求めたものです。正規化をしていない点

,

に関しては、

で正規化を行うと

,

と表せるので、

と表せ、と置き、

を基礎行列と呼びます。

のランクについて、

(

を変形してランクを調べる操作をすると分かる)、

から、

である[2]と言えます。(

についても同様です。)

エピ極、エピポーラ線の求め方

画像1の光学中心を画像2の光学中心に投影した点がエピ極です(Fig1.の

)。また、

と

を結んだ線をエピポーラ線と呼びます。すべてのエピポーラ線はエピ極を通過します。これは、

と表すことが出来ます。(どんなに対しても

によって

と対応づけることが出来る。)ここから、

ということが分かり、これを解くことでが求まります。(特異値分解で解ける)

を通るエピポーラ線は、

として求めることが出来ます。これはという直線を表し、

は直線の係数ということになります。

基礎行列の求め方

8点アルゴリズムというシンプルな方法で解くことを考えます。(1)を要素で表し、

とします。これを書き換えると、

ここで、

と表せます。対応点が8点ある場合、

となり、これを解くことでが求まります。(

の特異値分解で解きます。)

の性質として、

となるはずですが、対応点データが正確でない限り求めた解は

になるとは限りません。よって、最終的な解のランクが2になるように事後調整など行います[3]。

実装

以下の実装に、エピポーラ線を描く部分を加えました。tukurutanoshi.hateblo.jp

3段目左はカメラ1から物体を見た画像(画像1)、右はカメラ2から物体を見た画像(画像2)です。

カメラ1はワールド座標系と同じ座標軸、カメラ2はz方向に4だけ移動したもので、画像1,2ともエピポーラ線は画像中心で交わっています。

参考

[1]視覚の幾何学3 キャリブレーションhttp://www.wakayama-u.ac.jp/~wuhy/cv11.pdf

[2]正則行列と逆行列の諸性質,https://risalc.info/src/inverse-matrix.html#rank

[3]画像の三次元理解のための最適化計算[III], http://www.iim.cs.tut.ac.jp/~kanatani/papers/ieicefit3.pdf

[4]実践コンピュータビジョン, https://www.oreilly.co.jp/pub/9784873116075/index.html

2つの画像の対応点からから3次元上の点を求める

理論

ある3次元上の点をカメラ内部パラメータ行列

とカメラ外部パラメータ行列

を用いて画像上に投影した点を

とすると、以下の関係が成り立ちます[1]。

または、

はスケール調整の定数です。カメラ内部行列の

,

はそれぞれピクセル単位の焦点距離、

,

は画像中心を表します。カメラの固有パラメータという感じです。カメラ外部行列はカメラ姿勢を表し、3次元物体の座標をカメラ座標に変換する役割を持ちます。

同じカメラで別の視点からを投影した画像が2枚(画像1、画像2)あり、それぞれのカメラ内部・外部行列を合わせたものを

,

、画像上の投影点を

,

とすると、それぞれに対して(1)を適応して、

と表せます。

これを変形すると、

と書けます。これを解くことでが求まります。特異値分解で解くことが出来ます。

試してみた

3次元上の物体をカメラ行列,

を使ってそれぞれ画像1,画像2に変換し、その画像を3次元上に復元する例を作成しました。

カメラ行列のパラメータはそれぞれ変えることが出来ます。

Fig1. 1段目左:元の3次元上の物体、右:復元した3次元物体

(2段目:元の物体のカメラ座標上の点。ここでは説明していない)

3段目左:画像1、右:画像2

元の3次元物体と復元結果が一致しています。

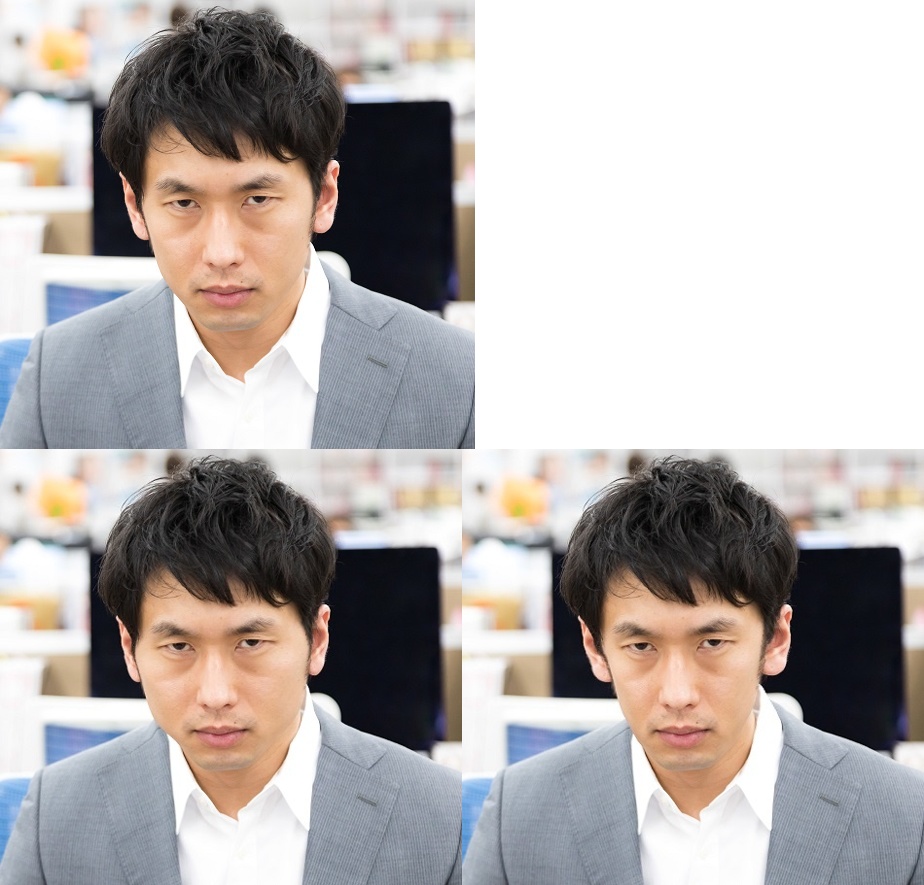

輪郭を変えて顔を太らせる、痩せさせる

と同じモチベーションで輪郭を変えてみました。太ります。痩せます。

Fig1. 左上:元画像、左下:太り、右下:痩せ

顔特徴点の抽出

顔パーツを選択して置換する - つくるって楽しい、と同じです。

輪郭の内側/外側に三角形を作る

顔の輪郭の特徴点とその近くの特徴点を三角形で結びます。輪郭の外側にも適当に点を配置し三角形を作ります。

Fig2. 三角形の配置

輪郭点の移動と変形

輪郭点を移動させます。ここでは顔の外側方向にに5pixcelとしました。三角形ごとに移動前後から対応するAffine変換を求めて変形させます。

Fig3. 左:移動前後の特徴点(青:移動前、赤移動後)、右:変形結果

移動座標の対応点からAffine変換の係数を求める

3組の対応点からAffine変換を求める方法について。opencvだとcv2.getAffineTransform()に対応します。なぜ3点なのでしょう。

理論

Affine変換によりが

に変換される時次のように書けます。

(1)を書き換えます。

(2)は1対応点のみの場合ですが、N個の対応点がある場合は次のように拡張できます。

(3)を以下のように表記します。

これは最小二乗法の行列表現[1]ですね。が正則ならば

は

と求めることが出来ます。の未知数は6つなので、対応点が3つあれば(5)の方法で求めることが出来ます。

また、対応点が4つ以上の場合はが正則でないので逆行列が求められませんが、以下の式で解くことが出来ます。

(6)はが正則な時の唯一つの解になるそうです。[1]

試してみた

時計回りに60度、x,y方向にそれぞれ5,3ずつ移動する変換Mを用意します。((1)の形式の変換行列です。)

theta = 60 tx, ty = 5, 3 M = np.array([[np.cos(np.deg2rad(theta)), -np.sin(np.deg2rad(theta)), tx], [np.sin(np.deg2rad(theta)), np.cos(np.deg2rad(theta)), ty]], float)

Mを出力。

M: [[ 0.5 -0.8660254 5. ] [ 0.8660254 0.5 3. ]]

3点の場合

座標変換前の点の集合。

X = np.array([[15, 5, 1], [25, 10, 1], [20, 15, 1]])

変換。

X_tfm = M.dot(X.T)

前後をプロット。赤:移動前、青:移動後。

(5)から変換行列を計算。Mと一致しています。

M_slv = np.linalg.inv(XX).dot(XX_tfm)

M_slv: [ 0.5 -0.8660254 5. 0.8660254 0.5 3. ]

4点の場合

座標変換前の点の集合。変換。

X = np.array([[15, 5, 1], [25, 10, 1], [20, 15, 1], [18, 18, 1]]) X_tfm = M.dot(X.T)

(6)から変換行列を計算。Mと一致しています。

M_slv = np.linalg.inv(XX.T.dot(XX)).dot(XX.T).dot(XX_tfm)

M_slv: [ 0.5 -0.8660254 5. 0.8660254 0.5 3. ]

参考

[1]最小二乗法の行列表現(単回帰,多変数,多項式),https://mathtrain.jp/leastsquarematrix

顔パーツを選択して置換する

検出した顔パーツをすべて含むよう部分をスワップする例[1]を参考に、目、口などパーツを選択して置換する例を作成しました。Fig1では、右目、左目、口を置換しています。眼が青く、唇ぷるんになっています。

Fig1. 左上:パーツ交換元、左下:交換先、右下:交換後

顔パーツの検出

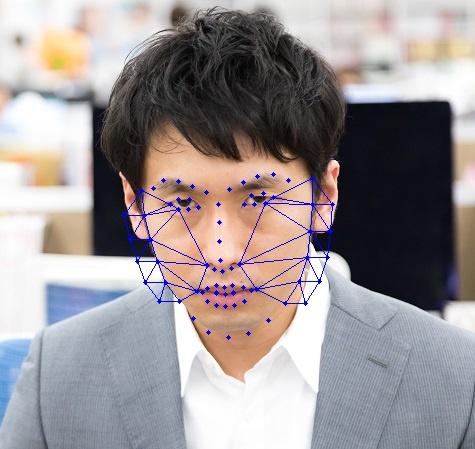

[1]と同様にdlibという機械学習のライブラリの顔パーツ検出を使用しています。dlibの顔パーツ検出はOne Millisecond Face Alignment with an Ensemble of Regression Trees[2]という回帰で特徴点を検出する方法の実装だそうです。

顔の特徴点を68点で記述したデータセットiBUG 300-W datasetを学習した結果がdlibで提供されています。

Fig2. 特徴点検出結果

パーツを三角形ごとに変形

顔パーツを構成する特徴点から3点ずつ選びパーツを三角形の集合にします。左目なら4つの三角形になります。三角形ごとに対応するAffine変換を求めてパーツを変形します。三角形に分けることでAffine変換のみで画像が変形できます。

Fig3. 三角形の変形

パーツを合成

変形後のパーツを合成します。単純な置き換えではパーツのつなぎ目が目立ってしまうので、openCVのseamlessClone()を使うことで変形先画像に違和感なく画像を合成します。ポワソン方程式を画像合成に応用した手法Poisson Image Editing[3]の実装ということです。

Fig3. 左:単純な置き換え、右:つなぎ目を目立たないように合成

コード

pyCodes/facePartsSwap at master · misakikobayashi1984/pyCodes · GitHub

参考

[1]Face Swap using OpenCV ( C++ / Python ),<https://www.learnopencv.com/face-swap-using-opencv-c-python/>

[2]Vahid Kazemi and Josephine Sullivan(2014),One Millisecond Face Alignment with an Ensemble of Regression Trees,CVPR 2014

[3]Patrick Perez, Michel Gangnet, and Andrew Blake(2003),"Poisson Image Editing",SIGGRAPH2003